La stagione elettorale è cominciata con brividi naturali, tipici delle competizioni in cui gli stravolgimenti non sono imputabili a taumaturgici interventi a connotazione tecnologica. L’esperienza sarda è risultato esclusivo di una gestione “non ottimale” della Regione da parte dello schieramento che è stato punito da chi è andato a votare.

Probabilmente proprio questa “naturalezza” del mutamento di opinioni ed equilibri correlati induce a temere che in un futuro molto prossimo la partita non escluderà il ricorso a strumenti cibernetici per ottenere risultati corrispondenti alle aspettative.

In un “corsivo” precedente si è fatto cenno alla possibilità di affidare all’intelligenza artificiale la modifica di video partendo da filmati preesistenti. Sappiamo che lo scenario delle consultazioni non si limita al territorio nazionale o comunitario, perchè gli interessi in gioco valicano qualunque confine e le interferenze possono piovere anche da “nubi” geograficamente fuori zona…

Si è fatto cenno all’abbinamento di sottotitoli non corrispondenti alle dichiarazioni di giornalisti e intervistati che possono illudere lo spettatore di fruire di una utile traduzione di sequenze “straniere” la cui conoscenza è di potenziale importanza…. Si è accennato ai “deep fake” e alla facilità di creare video completamente falsi in cui appaiono protagonisti della scena politica o economica che in realtà non hanno mai fatto o detto quel che si vede sullo schermo del televisore o di un computer o sul display di un tablet o di uno smartphone.

A voler riprendere il sorvolo appena iniziato con la manipolazione di video, si può planare sulla facile alterazione di immagini fotografiche.

Non sono soltanto le telecamere a fornire il materiale da modificare a proprio piacimento per perseguire i propri scopi. Le opportunità fraudolente imperniate sulle foto sono davvero infinite.

Un Paese straniero, che abbia intenzione di sconquassare gli equilibri di una Nazione avversa o semplicemente non alleata, può avvalersi di software generatori “text-to-image”. A fronte di un input testuale con cui l’operatore dice cosa vorrebbe nell’immagine finale, il computer è capace di creare qualunque situazione anche irreale che può alterare nell’opinione pubblica la percezione di fatti ed eventi.

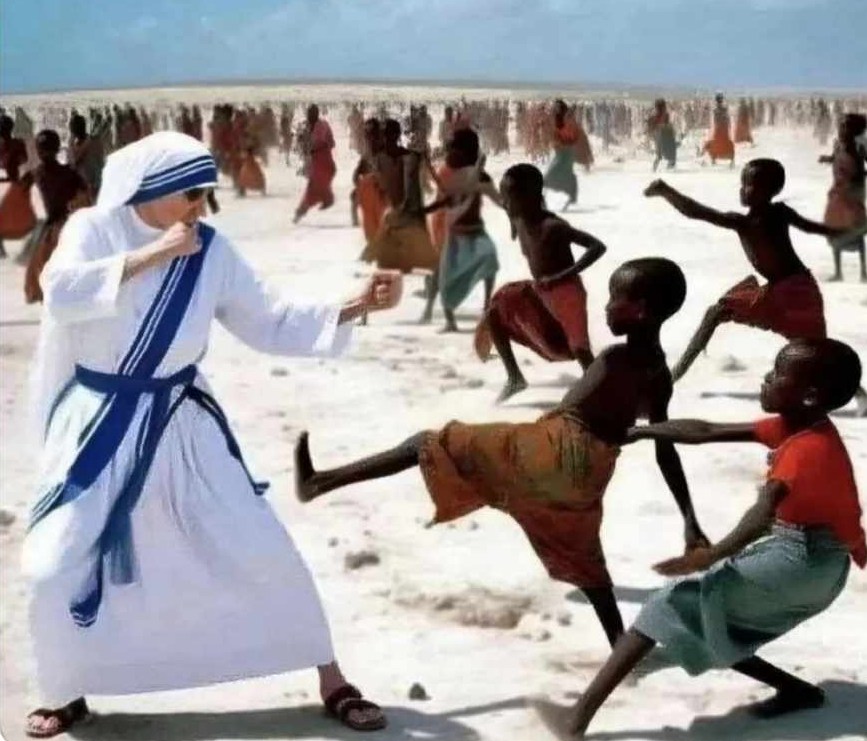

Il gioco è semplice e la dimostrazione della sua efficacia è data da una surreale foto diventata virale in questi giorni, che simula l’esito di una richiesta formulata ad un sistema di intelligenza artificiale. La “macchina” a cui sarebbe stato domandato di raffigurare “Madre Teresa di Calcutta che combatte la povertà” ha trasformato la donna in una sorta di karateka che prende a calci una torma di bambini indigenti.

I risultati grotteschi magari strappano un sorriso, ma l’obiettivo di chi opera su questo fronte non è certo quello di far divertire. La costruzione di situazioni che non hanno mai avuto luogo è agevole e alla portata di tutti.

Se certi “scatti” sono abbastanza innocui in condizioni di quotidiana normalità, si rivelano pericolosissimi nelle delicate fasi di crisi economica, finanziaria o politica.

Nella guerra di propaganda gli specialisti di questo genere di combattimento sono in grado di creare falsi profili social ricchi di ogni dettaglio che possono rivelarsi di enorme impatto nelle azioni di “influenza”.

La produzione di materiale di quel genere va a riempire la faretra dei leader a caccia di consenso. Le frecce al loro arco sono destinate a centrare il bersaglio in proporzione alla verosimiglianza delle foto adoperate per dare enfasi a discorsi o dichiarazioni. Se il dardo trafigge la buona fede o la dabbenaggine di chi guarda, il processo di inquinamento informativo è avviato e nel giro di poche ore la notizia artefatta fa il giro del mondo.